函数计算,请问下调用client.pull_logs方法超时怎么处理啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

超时是指在一定时间内没有得到预期的响应。当调用client.pull_logs方法超时时,可以考虑以下几种处理方式:

增加超时时间:可以尝试增加client.pull_logs方法的超时时间,看是否能够得到预期的响应。例如,可以将超时时间从默认的几秒钟增加到几十秒钟,或者根据具体情况进行调整。

重试机制:可以使用重试机制来处理超时问题。当client.pull_logs方法超时时,可以尝试重新调用该方法,直到得到预期的响应或达到最大重试次数为止。可以设置重试次数和重试间隔,以便在一定时间内尝试多次。

检查网络连接:超时可能是由于网络连接不稳定或网络延迟引起的。可以检查网络连接是否正常,并确保网络稳定。如果网络连接不稳定,可以尝试切换到其他网络环境或使用更稳定的网络连接方式,如使用有线网络连接代替无线网络连接。

优化代码逻辑:如果超时问题是由于代码逻辑问题引起的,可以对代码进行优化,以减少调用client.pull_logs方法的次数或减少处理时间。例如,可以使用并发编程技术,将任务分解为多个子任务并行处理,以提高性能和效率。

与服务提供商联系:如果以上方法仍无法解决超时问题,可以与服务提供商联系,咨询他们是否有其他解决方案或是否存在其他原因导致超时。服务提供商可能会提供一些特定的配置或建议,以解决超时问题。

处理函数计算调用client.pull_logs方法超时的方法有以下几种:

增加超时时间:在调用client.pull_logs方法时,可以调整超时时间设置,延长等待时间,例如将默认的3秒超时时间增加到更大的值。

优化代码逻辑:检查代码逻辑是否存在资源瓶颈或者运行效率较低的问题,可以尝试对代码进行优化,减少运行时间。

批量获取日志:如果需要获取的日志数量较大,可以考虑进行批量获取,而不是一次性获取所有日志。可以根据实际需求调整每次获取的日志数量。

异步调用:将client.pull_logs方法的调用改为异步调用,这样可以同时发起多个异步请求,提高并发处理能力。

使用多线程或多进程:将client.pull_logs方法的调用放在多个线程或多个进程中执行,利用并发的能力提高处理速度。

增加函数计算资源配额:如果超时是由于函数计算资源配额不足导致的,可以考虑增加资源配额。可以在阿里云控制台或者通过API进行相应的配置。

以上是常见的处理方法,具体的选择和调整可以根据实际情况进行。

如果你在调用client.pull_logs方法时遇到了超时问题,可以使用以下方法进行处理:

增加超时时间:可以增加client.pull_logs方法的超时时间,以便更好地处理超时问题。 增加重试次数:可以增加client.pull_logs方法的重试次数,以便在遇到超时问题时能够更好地处理。 使用异常处理机制:可以使用异常处理机制来捕获client.pull_logs方法可能会抛出的异常,并进行相应的处理。 使用其他的API接口:如果你的应用程序需要使用其他的API接口来获取日志,可以考虑使用这些API接口来代替client.pull_logs方法。

在函数计算中,如果调用 client.pull_logs 方法超时,您可以尝试以下几种处理方式:

增加超时时间:可以通过增加 timeout 参数的值来延长 client.pull_logs 方法的超时时间。例如,将超时时间设置为60秒:

client.pull_logs(logstore_name, shard_id, from_time, to_time, timeout=60)

检查网络连接:确保您的函数计算服务可以正常访问日志服务。您可以尝试使用其他网络工具(如 ping 命令)来测试网络连接是否正常。

检查日志服务配置:确认您在调用 client.pull_logs 方法时,提供了正确的日志服务配置。包括 endpoint、access_key_id、access_key_secret 等参数。

检查日志服务状态:确保日志服务处于正常运行状态,没有发生故障或者限流等情况。您可以查看日志服务的控制台或者日志服务的监控指标来获取更多信息。

分批次拉取日志:如果一次拉取的日志量过大导致超时,您可以尝试按照时间范围或者分片进行分批次拉取。例如,将时间范围划分为多个小的时间段,分别调用 client.pull_logs 方法进行拉取。

优化日志查询条件:如果您的查询条件过于复杂或者查询结果过大,可能会导致超时。您可以尝试优化查询条件,缩小查询范围,或者使用更精确的查询条件来减少数据量。

楼主你好,超时问题可能有多种原因,可以尝试以下几种处理方法:

增加超时时间:在调用client.pull_logs方法时,设置一个较长的超时时间,例如增加到60秒或更长,看是否可以解决超时问题。

检查网络连接:确保函数计算服务与日志服务之间的网络连接正常。可以通过其他方式测试网络连接性,例如使用ping命令检查网络延迟或使用curl命令检查API可达性。

检查日志服务配置:确保已正确配置日志服务。检查是否已正确设置日志库、日志主题以及相关权限。

分批获取日志:如果拉取日志数据量较大,可以考虑分批获取日志。可以使用client.pull_logs方法的offset参数来指定获取日志的起始位置,然后多次调用该方法来获取所有日志数据。

并发请求:如果你的场景允许并发请求,可以使用多线程或者异步方式发送多个请求,以提高拉取日志的效率。

当调用client.pull_logs方法超时时,可以尝试以下几种处理方法:

client.pull_logs方法时增加超时参数,将超时时间设置得更长一些。例如,使用timeout参数来指定超时时间(以秒为单位):client.pull_logs(timeout=10) # 设置超时时间为10秒

根据实际情况,适当增加超时时间可能有助于成功获取日志信息。

检查网络连接: 确保函数计算服务和调用client.pull_logs方法的机器之间的网络连接正常。如果网络连接不稳定或存在问题,可能会导致超时错误。可以尝试通过其他方式测试网络连接,如ping函数计算服务的地址,以确定是否存在网络问题。

分批获取日志: 如果要获取的日志数据量较大,可以考虑将日志分成多个较小的批次进行获取。这样可以避免一次性获取过多日志数据而导致超时错误。可以使用client.pull_logs方法的start_time和end_time参数来限制获取的日志时间范围。

重试机制: 如果超时错误是偶发性的,并且不是由于网络连接问题引起的,可以尝试使用重试机制。可以使用try-except语句捕获超时异常,并在捕获到异常后进行重试操作。例如:

import time

max_retries = 3

retry_interval = 1

for i in range(max_retries):

try:

client.pull_logs()

break

except TimeoutError:

if i == max_retries - 1:

# 达到最大重试次数,仍然超时

print("超时错误,已达到最大重试次数")

else:

time.sleep(retry_interval)

这段示例代码将尝试最多3次调用client.pull_logs方法,如果超时错误仍然发生,则输出相应的提示信息。

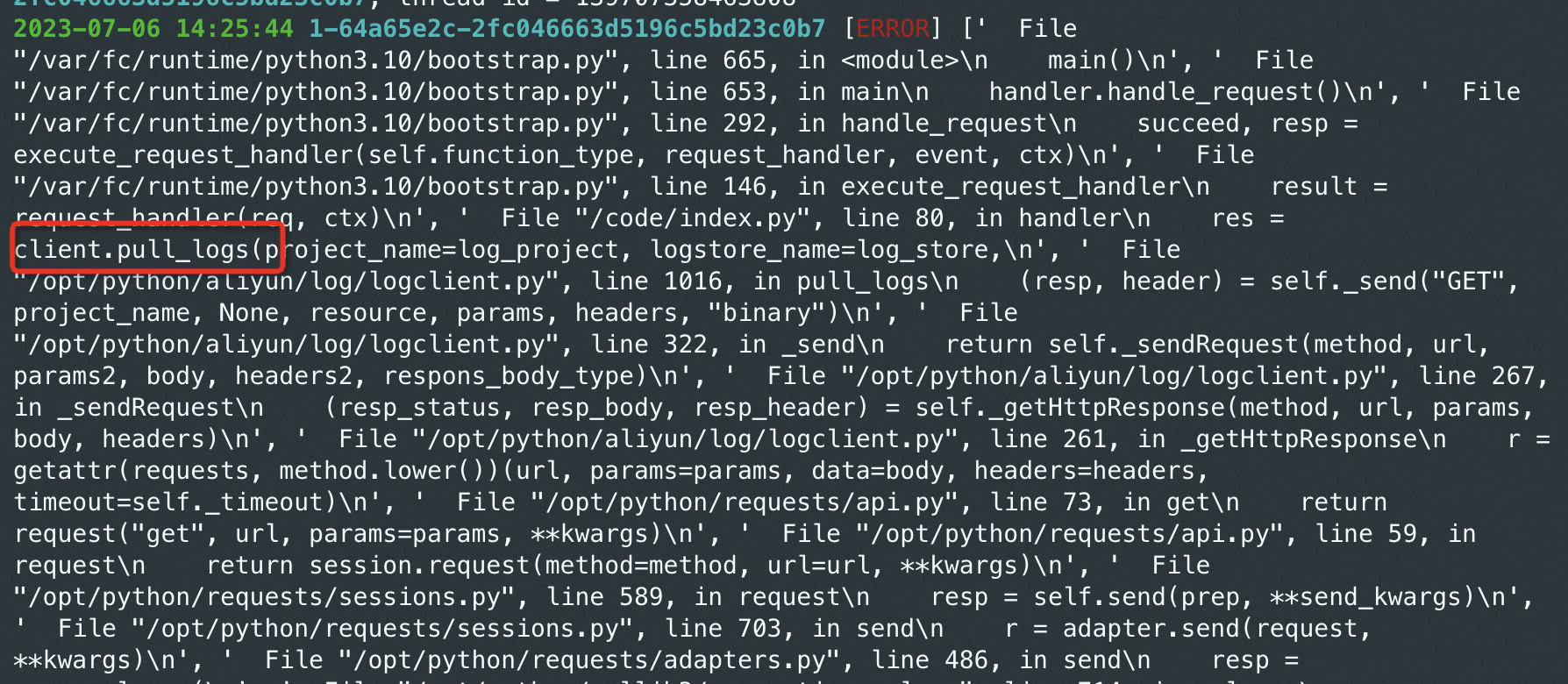

根据您提供的截图,调用client.pull_logs方法超时可能有以下几种处理方式:

增加超时时间:可以尝试增加client.pull_logs方法的超时时间,以便给函数计算更多的时间来完成操作。您可以查看相关文档或者函数计算的SDK文档,了解如何设置超时时间。

检查网络连接:超时可能是由于网络连接不稳定导致的。您可以检查本地网络环境,确保网络连接正常。如果是在云服务器上部署函数计算,可以检查云服务器的网络配置,确保网络畅通。

检查函数计算配置:超时还可能是由于函数计算的配置不合理导致的。您可以检查函数计算的配置项,确保配置项正确,并根据实际情况进行调整。

分批拉取日志:如果一次性拉取所有日志超时,可以尝试分批拉取日志。可以根据函数计算的日志量进行切割,分批拉取,减少一次性拉取的压力。

联系函数计算的技术支持:如果尝试以上方法仍然无法解决问题,建议您联系函数计算的技术支持,向他们详细描述问题并提供相关的日志和截图,以便他们能够更好地帮助您解决问题。

需要注意的是,具体处理方式可能因具体情况而异,建议根据实际情况进行调整。

参考

增加超时时间:您可以尝试在调用client.pull_logs方法时增加超时时间,以便等待函数计算服务端处理完成。在Python SDK中,可以使用timeout参数来设置超时时间,例如: Copy client.pull_logs(project_name, logstore_name, shard_id, count, timeout=30) 上述代码将超时时间设置为30秒。如果函数计算服务端处理时间较长,可以适当增加超时时间,以确保请求能够得到响应。

优化网络连接:您可以检查网络连接是否稳定,并尝试使用其他网络连接方式进行访问。例如,可以使用VPN等方式进行访问,以提高网络连接的稳定性。

扩容函数计算服务:如果函数计算服务端资源不足,可以尝试增加函数计算服务的实例数或者规格,以提高服务的处理能力。您可以登录阿里云控制台,进入函数计算服务控制台,选择相应的函数服务并进行扩容操作。

当在函数计算中调用 client.pull_logs 方法超时时,你可以尝试以下几种方法来处理:

增加超时时间:在调用 pull_logs 方法之前,可以通过设置适当的超时时间来增加函数执行的最大时间限制。你可以根据具体情况调整超时时间,以确保足够的时间完成日志拉取操作。

检查网络连接:超时可能是由于网络连接问题导致的。请确保函数运行环境与目标资源之间的网络连接正常,并且没有防火墙或其他网络配置限制导致无法建立连接。

优化查询条件:如果查询的日志量较大,可能需要优化查询条件以减少返回结果的大小。可以考虑使用更精确的查询条件、时间范围过滤等方式来缩小查询范围,降低日志的拉取和处理所需的时间。

异步处理:如果实时日志拉取不是必需的,你可以考虑使用异步处理方式,将日志拉取请求提交到消息队列或任务队列中,在后台进行处理,避免超时问题影响函数的执行。

使用分页查询:如果日志量很大,可以考虑使用分页查询的方式,每次只获取部分日志并进行处理。这样可以避免一次性拉取所有日志导致的超时问题。

增加资源配额:在函数计算控制台中,你可以尝试增加函数的内存和超时配额来提高函数执行的性能和稳定性。

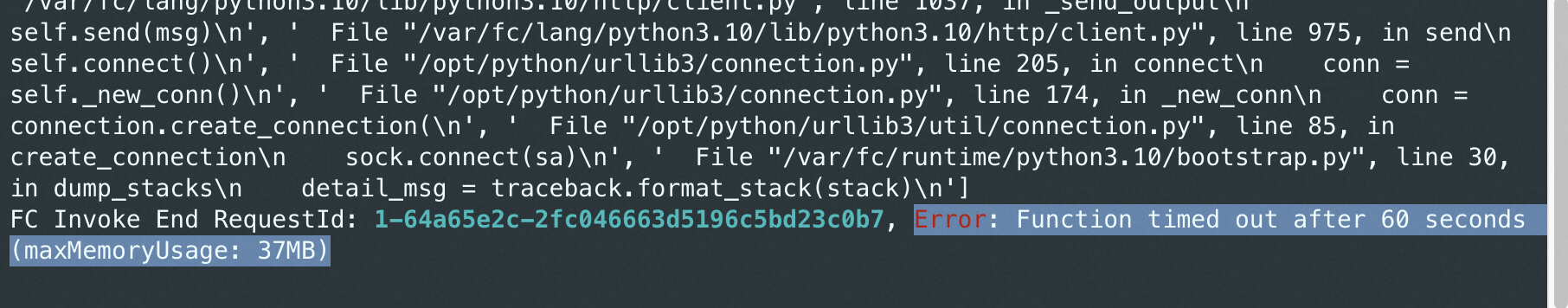

这个错误是指客户端在尝试通过调用 client.pull_logs 方法来获取数据时,由于超时已经达到了 60 秒,因此无法再继续执行。

要处理这个错误,可以在客户端中设置一个计时器,在调用 client.pull_logs 方法时,等待一段时间后再继续执行。具体的实现方法可以根据实际情况来定,可以使用 Thread.sleep 方法来模拟等待一段时间,也可以使用 Timer 类来设置一个自定义的计时器。

另外,如果客户端无法正常通信,也可能会导致超时错误。因此,需要检查客户端与服务器之间的网络连接是否正常,并及时处理相关的错误。