Hi阿里云,DataWorks中 我们使用maxCompute+dataworks跑spark-examples_2.12-3.3.2.jar mainClass: org.apache.spark.examples.SparkPi,遇到这个问题,请问这是什么原因呢? 2023-06-30 17:04:42 INFO --- Invoking Shell command line now --- 2023-06-30 17:04:42 INFO ================================================================= /opt/taobao/tbdpapp/spark/spark-3.x spark-3.x Picked up JAVA_TOOL_OPTIONS: -Duser.timezone=Asia/Singapore Exception in thread "main" java.lang.NoClassDefFoundError: com/aliyun/odps/OdpsException at com.aliyun.odps.SubmitJob.registerSigHandler(SubmitJob.java:88) at com.aliyun.odps.SubmitJob.main(SubmitJob.java:24) Caused by: java.lang.ClassNotFoundException: com.aliyun.odps.OdpsException at java.net.URLClassLoader.findClass(URLClassLoader.java:381) at java.lang.ClassLoader.loadClass(ClassLoader.java:448) at sun.misc.Launcher$AppClassLoader.loadClass(Launcher.java:331) at java.lang.ClassLoader.loadClass(ClassLoader.java:380) ... 2 more 2023-06-30 17:04:57 INFO  执行一直等待 wait,需要购买 什么单独资源

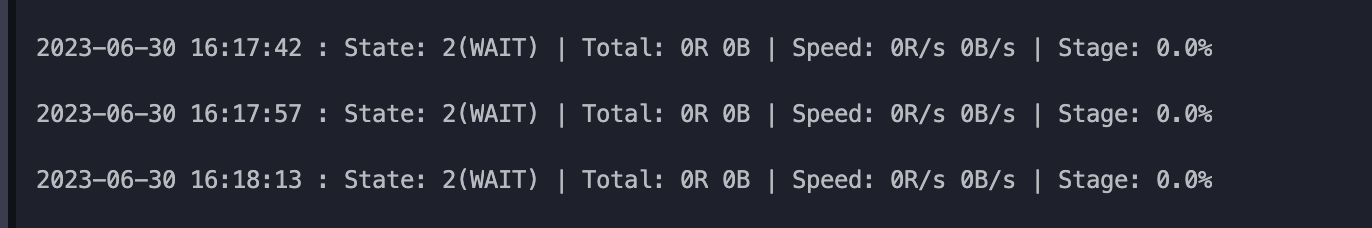

执行一直等待 wait,需要购买 什么单独资源

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

orks的Region不匹配导致的。

具体来说,MaxCompute项目和DataWorks所在的Region需要保持一致,否则可能会出现连接失败等问题。您可以在DataWorks的项目管理页面中,查看您的项目所在的Region,在MaxCompute控制台中确认您的项目所在的Region是否与DataWorks一致。

如果Region不一致,您可以将MaxCompute项目迁移到与DataWorks相同的Region中,或者在DataWorks中创建一个与MaxCompute项目所在Region相同的项目。

另外,还需要确保您的MaxCompute项目和DataWorks的AccessKey和EndPoint设置正确。您可以在DataWorks中的数据源配置页面中,检查AccessKey和EndPoint的设置是否正确,并根据需要进行修改。

如果上述方法无法解决问题,请在DataWorks中查看任务的日志和错误提示,以获取更多的信息,并根据提示进行排查和修复。

这个错误提示是由于在DataWorks中使用了MaxCompute和Spark时,无法找到OdpsException类导致的。这可能是由于以下原因之一引起的:

缺少OdpsException类:请确保您的代码中包含了OdpsException类,并且它位于正确的路径下。如果您的代码是从其他地方导入的,请检查导入的包是否包含了OdpsException类。 缺少依赖项:如果您的代码依赖于其他库或框架,请确保这些依赖项已经正确导入并且可用。可以通过检查依赖项的文档或查看控制台输出是否还有其他相关的错误提示来确定是否存在缺少的依赖项。 版本不兼容:请确保您使用的MaxCompute和Spark版本与您的代码和依赖项兼容。可能存在版本不兼容的问题,导致某些类无法找到或出现异常。 为了解决这个问题,您可以尝试以下步骤:

检查您的代码中是否包含了OdpsException类,并确保它位于正确的路径下。 检查您的代码是否存在其他依赖项,并确保它们已经正确导入并且可用。 检查您的MaxCompute和Spark版本是否与您的代码和依赖项兼容。如果可能存在版本不兼容的问题,请尝试更新或降级版本以解决问题。 如果以上步骤无法解决问题,您可能需要进一步检查您的代码和环境设置,或者咨询相关技术支持以获取更多帮助。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。