DataWorks离线同步数据写入kafka超时报脏数据怎么办?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

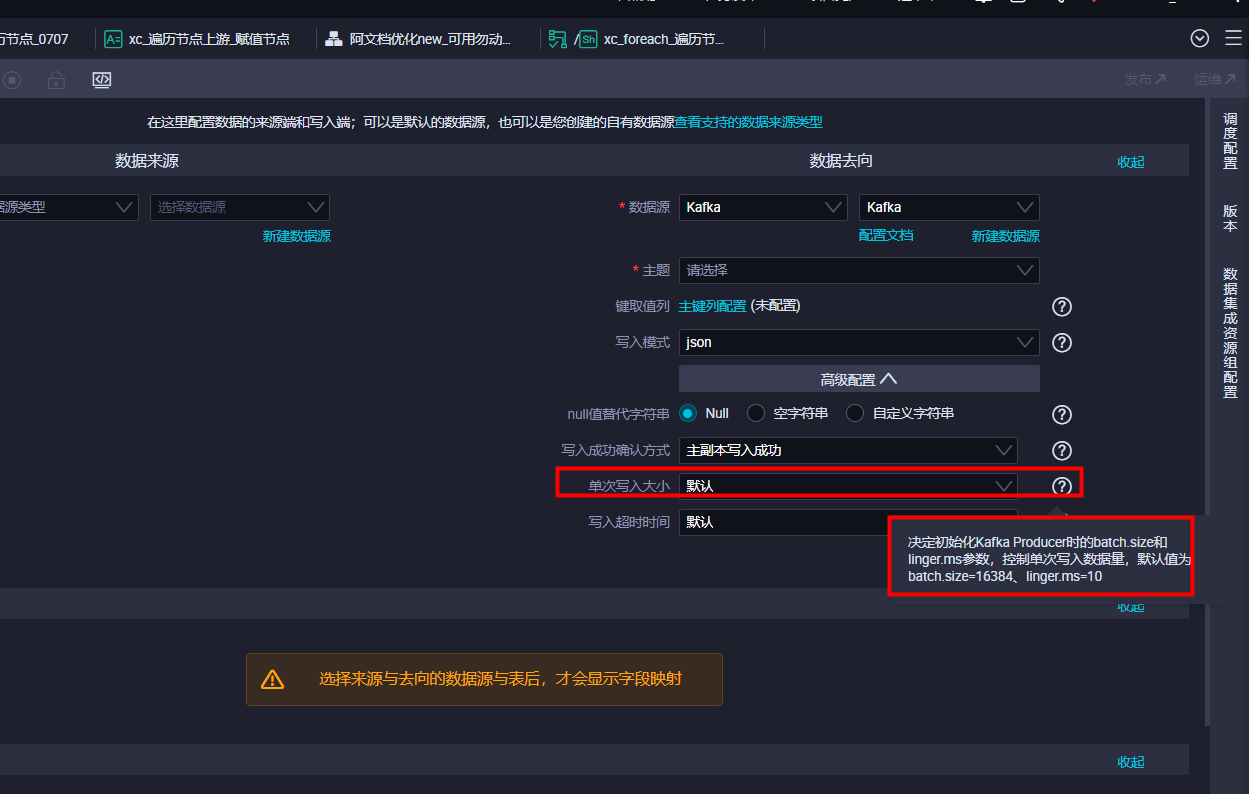

当来源端数据量大时,数据在30s内没有完全写入kafka相应topic内,会出现该问题。 目前您可以通过配置单次写入大小这个配置项来调大相应的参数。即通过该参数修改linger.ms以及batchsize值。 ,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。