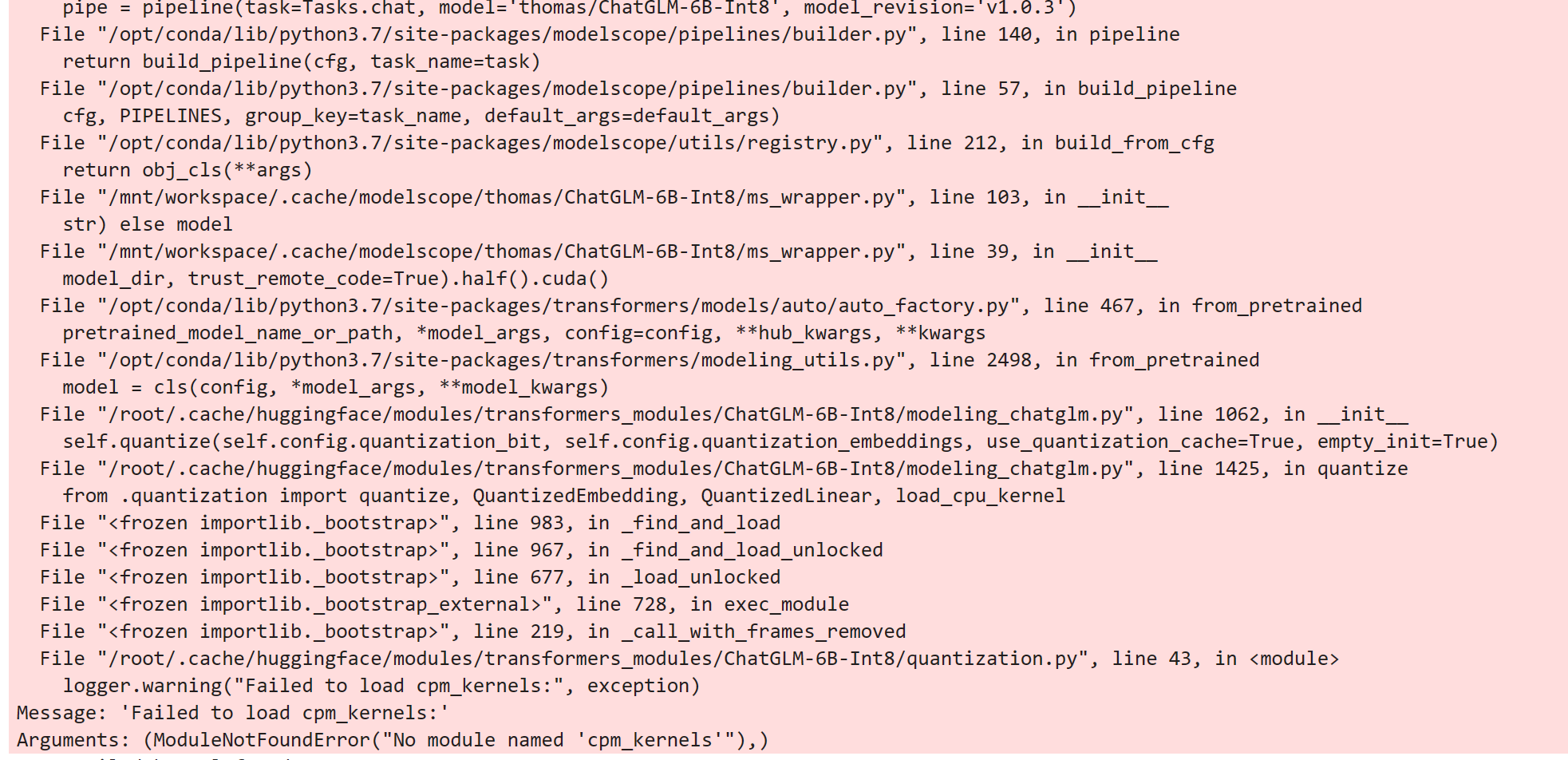

https://modelscope.cn/models/thomas/ChatGLM-6B-Int8/summary ModelScope报错信息什么原因?

用的gpu环境

用的gpu环境

ModelScope 是一个用于在 PyTorch 中管理模型实例的上下文管理器,通常用于在分布式训练中管理模型副本。如果在 GPU 环境下使用 ModelScope 时出现错误,可能是以下几个原因之一:

未正确安装 DDP(分布式数据并行)库:在分布式训练中,需要使用 DDP 库来管理模型副本和数据并行。如果未正确安装 DDP 库,ModelScope 可能会引发错误。请确保安装了最新版本的 DDP 库。 未正确设置环境变量:如果使用 GPU 进行分布式训练,需要设置一些环境变量来告诉进程如何找到其他进程和 GPU。请确保已正确设置这些环境变量,如 DISTRIBUTED_SERVE、DISTRIBUTED_NUM_SOCKET_PROCESSORS、DIST_BACKEND 等。 未正确配置进程间通信:在使用 ModelScope 时,需要确保各个进程之间能够进行正确的通信。请检查进程间通信是否配置正确,如使用 Gloo 后端、设置正确的 rank 和 world size 等。 以下是一个使用 ModelScope 的示例代码,可以帮助你排查问题:

import torch

import torch.distributed as dist

import ddp_backend

from ddp_backend import ModelScope

dist.init_process_group("gloo", rank=0, world_size=2)

with ddp_backend.ModelScope(0):

# 创建模型实例

model = MyModel()

model.to(device)

model.train()

# 训练循环中的代码...

# ...

dist.destroy_process_group() 如果仍然遇到问题,请提供更多详细信息,以便我更好地帮助你解决问题。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352