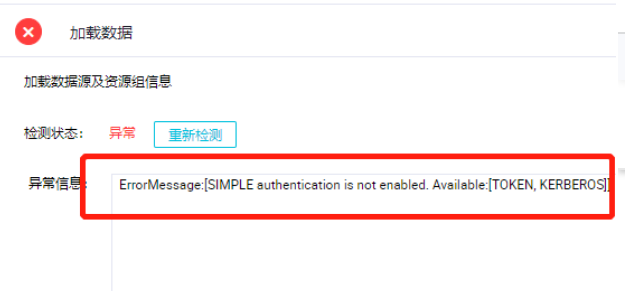

Dataworks上配置hdfs数据源,出现这个报错ErrorMessage:[SIMPLE authentication is not enabled. Available:[TOKEN, KERBEROS]]

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

该错误消息说明HDFS数据源启用了简单认证(SIMPLE authentication),不支持此种认证方式。在DataWorks中配置HDFS数据源时,需要选择“Kerberos认证”,并正确填写HDFS认证的相关信息,如Kerberos认证的Principal、Kerberos Keytab文件等。请您确认是否已正确配置,并重新进行连接测试。

重新创建 Hadoop 虚拟客户端,配置 kerberos ticket 路径。具体步骤如下: 1. 分别登录 Hadoop NameNode 节点和 DataNode 节点的客户端后台系统,执行以下命令查看 krb5cc_0 是否存在。 cd /tmp ls krb5cc_0 2. 若 krb5cc_0 不存在,则执行下面的命令再次进行证书配置,该文件会自动生成。 kinit -k -t /usr/hadoop/hadoop-3.0.0/etc/hadoop/hdfs.keytab hdfs/hmaster@HADOOP.COM 注意: /usr/hadoop/hadoop-3.0.0 为安装路径;所有 Hadoop 节点都需要进行证书配置。 3. 使用操作员登录 AnyBackup web 界面,打开资源 > 客户端界面。点击创建虚拟客户端按钮,选择 Hadoop 虚拟客户端,弹出新建虚拟客户端对话框,填入正确的客户端信息。 4. 点击代理客户端的选择按钮,选择 Hadoop 客户端,勾选所有已选择的客户端。在设置路径的输入框中填入 kerberos ticket 的路径:/tmp/krb5cc_0 ,然后点击应用按钮,再点击完成按钮返回新建虚拟客户端对话框。最后点击创建按钮,虚拟客户端创建成功。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。