flink cdc 抽MySQL数据,一开始抽一张表,checkpoint成功了,后面加了一张表,然后用一张表的时候的checkpoint路径启动,发现抽不了数,也不报错,什么原因?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用flink-cdc采集mysql数据时,会遇到各种问题,使用flink 1.15.0 和 flink-connector-mysql-cdc,直接引用会有版本冲突:flink-shaded-guava30和flink-shaded-guava18冲突,因为flink15使用的是guava30,而flink-connector-mysql-cdc的2.2版本用的是guava18。

解决冲突的办法可以选用重新编译flink-cdc-connectors,在git上下载2.2版本的flink-cdc-connectors源码,修改代码中用到flink-shaded-guava18的代码。

修改项目pom 把flink-shaded-guava的18.0-13.0版本升级到30.1.1-jre-15.0

最新master的2.3版本的flink-connector-mysql-cdc直接使用的就是flink-shaded-guava:30.1.1-jre-15.0,也可以替换成2.3版本。

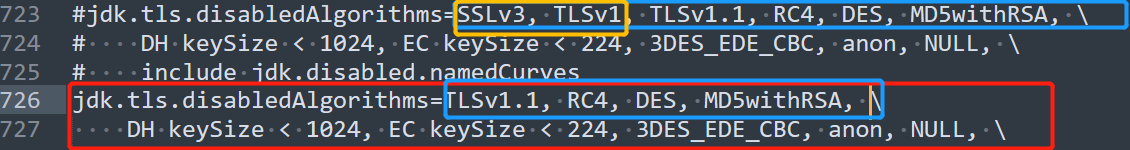

第一个多并发读没开checkpoint或者checkpoint设置比较大,第二个,RDS 5.6的只读实例binlog是简化版本,binlog里不包含数据 如果FlinkCDC获取MySQL数据库还是打印不出数据或报错 首先确保MySQL没问题,能读能写 打开JDK安装目录下的java.security文件 大概700+行处 jdk.tls.disabledAlgorithms=SSLv3, TLSv1, TLSv1.1, RC4, DES, MD5withRSA,

DH keySize < 1024, EC keySize < 224, 3DES_EDE_CBC, anon, NULL,

include jdk.disabled.namedCurves 删去第一行中的SSLv3, TLSv1即可:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。