请问下,在dataworks里部署里一个udf,udf内连接oss读取文件。处理比较大的数据量的时候会报这个错,数据量较小时不会,问下是什么原因

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

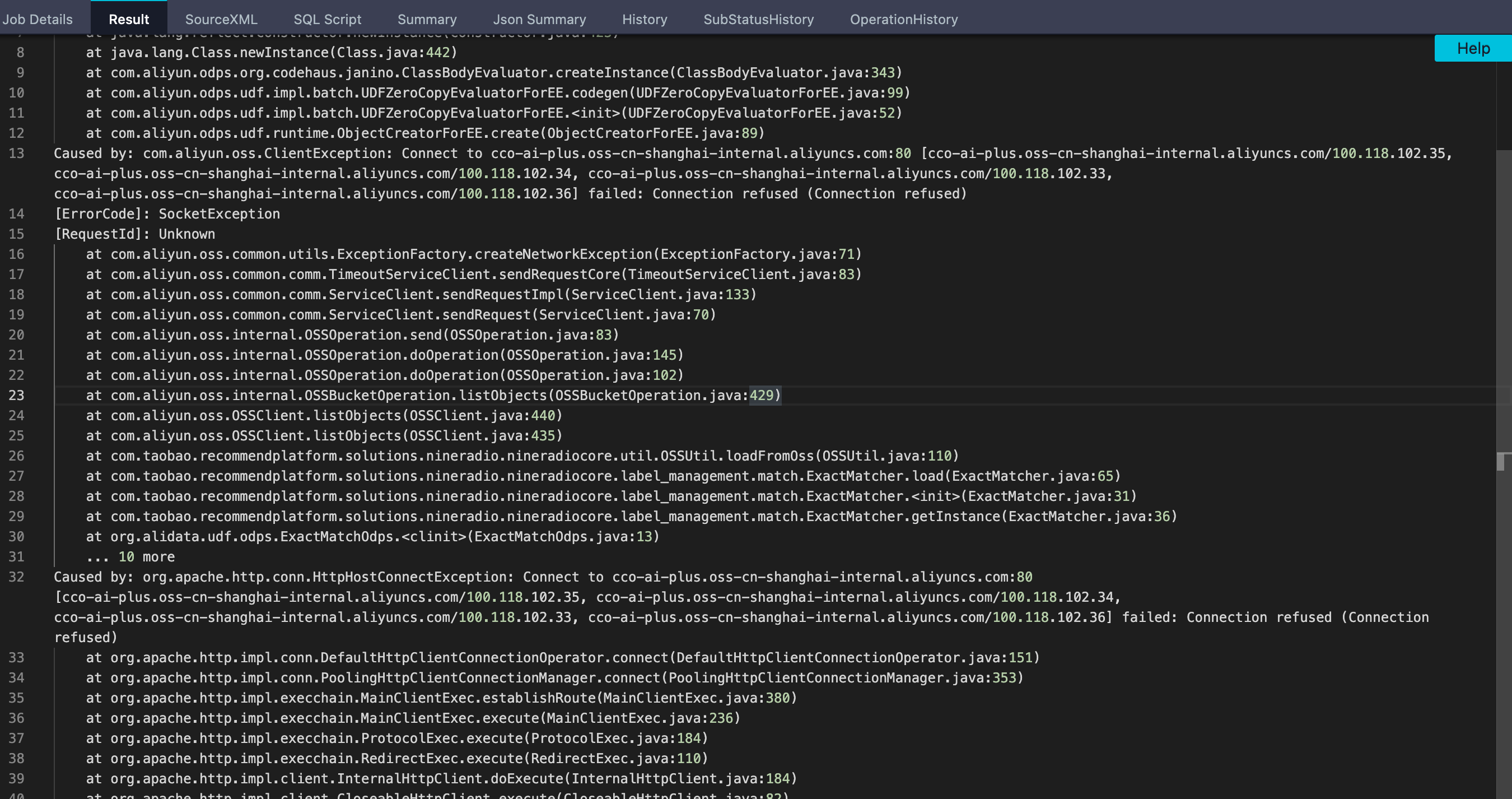

根据您提供的错误截图,可以看到错误信息是“java.io.IOException: Premature EOF”,这意味着在读取OSS文件时,遇到了文件读取到末尾但还未读完的情况。这通常是由于OSS文件无法按照预期大小读取导致的,或者是网络或IO异常导致读取中断而引起的。

在处理大数据量的时候,可能会有大量的数据需要读取和处理,如果网络情况不好或者OSS服务器响应不及时,可能会导致读取数据中断或不完整,进而导致这种错误的发生。为避免这种情况的发生,可以尝试以下几个方案:

同时,建议您在代码中增加异常处理和日志记录功能,以便更好地捕捉和记录类似错误的发生和处理结果,便于后续调试和优化。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。