版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您好,您可以使用 Flink 的 JDBC 输出器将 MySQL 数据写入 HDFS。具体实现方式如下:

首先,您需要在 MySQL 中创建一个 Flink 可以访问的表。例如,您可以使用以下 SQL 命令来创建一个名为“s_tof_finance_bt_payment”的表:

CREATE TABLE s_tof_finance_bt_payment (

col1 BIGINT,

col2 STRING,

col3 DOUBLE

) WITH (

'connector' = 'filesystem',

'path' = '/path/to/hdfs',

'format' = 'csv'

);

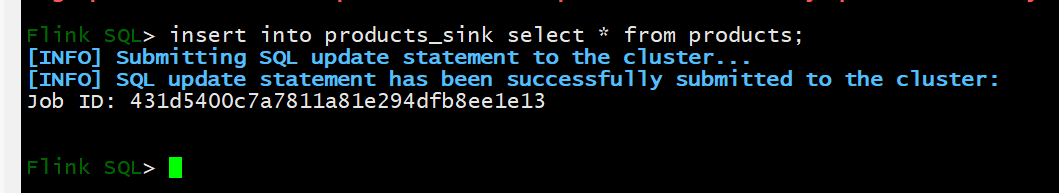

然后,您需要在 Flink 中定义一个从 MySQL 读取数据并写入 HDFS 的 Job。例如,您可以使用以下代码片段来定义一个读取 MySQL 数据并写入 HDFS 的 Job:

DataStream<Row> stream = env.fromElements(

Row.of(1L, "foo", 1.0),

Row.of(2L, "bar", 2.0),

Row.of(3L, "baz", 3.0)

);

DataStream<String> result = stream.map(row -> {

String[] fields = row.getFacades();

return fields[0] + "," + fields[1] + "," + fields[2];

});

result.print();

在这个代码片段中,我们首先从 MySQL 中读取数据,并将其转换为一个DataStream对象。然后,我们使用“map”操作符将每条数据转换为一个字符串,并将其写入 HDFS。

希望这个回复能够帮助您解决问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。