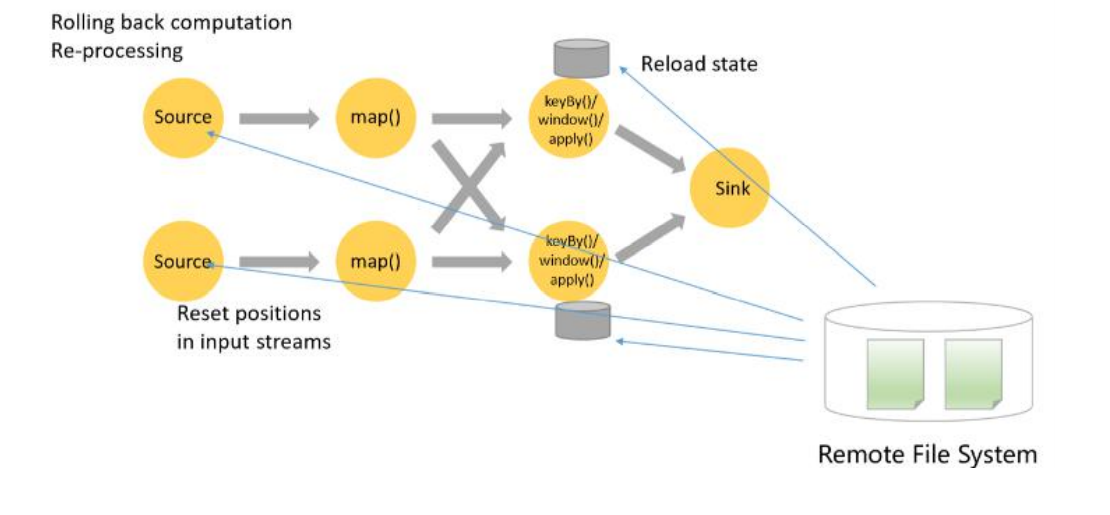

作业在很多情况下有可能会失败。失败之后重新去运行时,我们如何保证数据的一致性?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

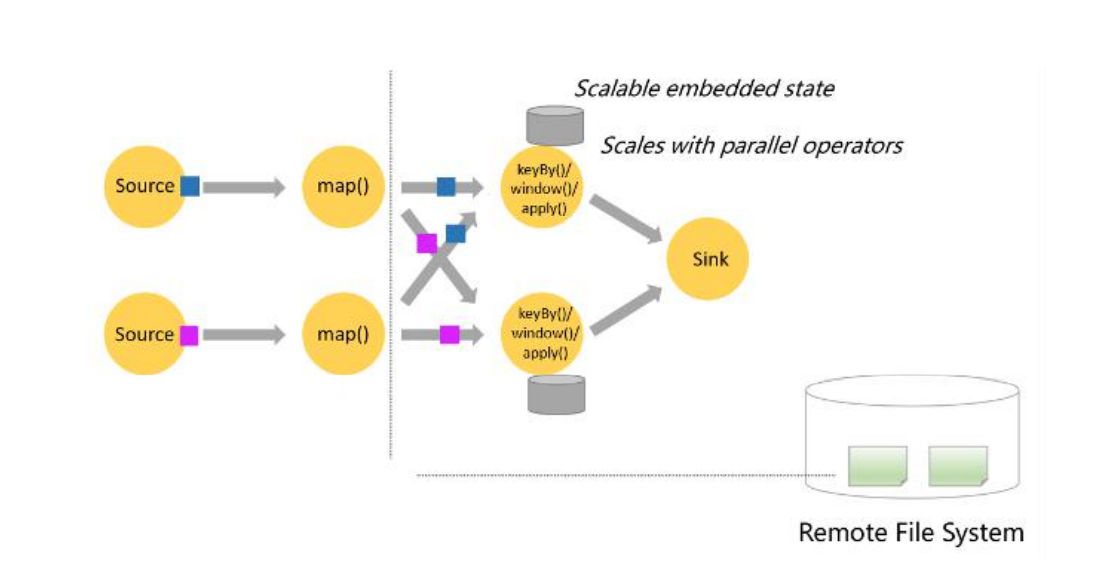

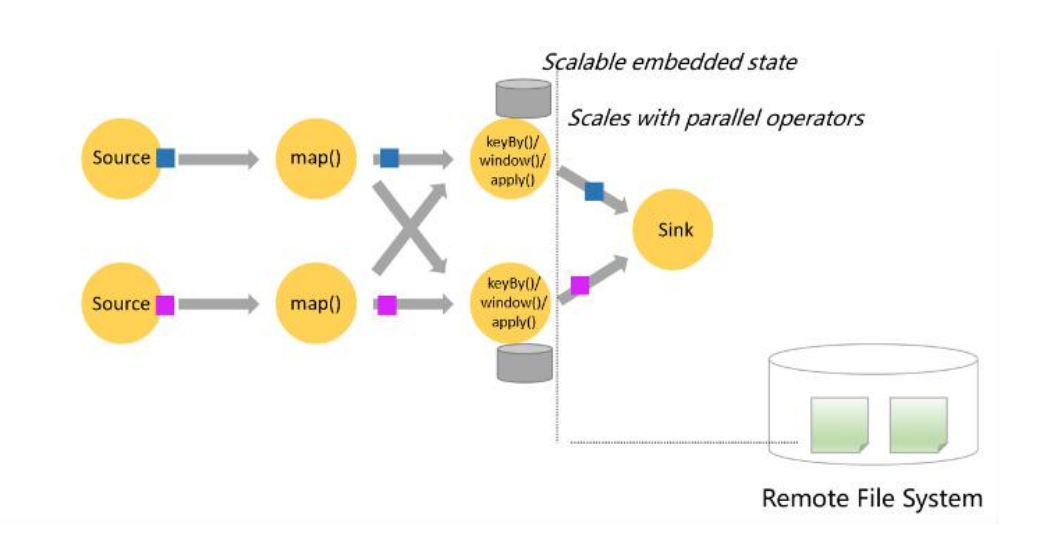

Flink 基于 Chandy-Lamport 算法,会把分布式的每一个节点的状态保存到分布式文件系统里面作为 Checkpoint(检查点),过程大致如图示。

首先,从数据源端开始注入 Checkpoint Barrier,它是一种比较特殊的消息;

其次,它会跟普通的事件一样随着数据流去流动,当 Barrier 到达算子之后,这个算子会把它当前的本地状态进行快照保存,当 Barrier 流动到 Sink,所有的状态都保存完整了之后,它就形成一个全局的快照。

这样当作业失败之后,就可以通过远程文件系统里面保存的 Checkpoint 来进行回滚:先把 Source 回滚到 Checkpoint 记录的 offset,然后把有状态节点当时的状态回滚到对应的时间点,进行重新计算。这样既可以不用从头开始计算,又能保证数据语义的一致性。

资料来源:《8-Apache Flink 必知必会》,下载链接:https://developer.aliyun.com/topic/download?id=1189

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。