能否举个Flink 作业描述和逻辑拓扑的例子?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

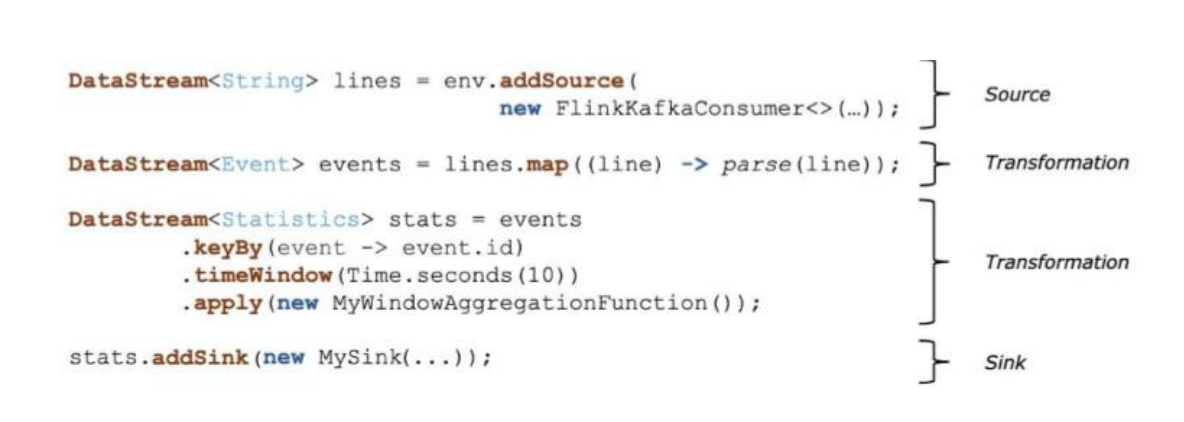

如图示,代码是一个简单的 Flink 作业描述。它首先定义了一个 Kafka Source,说明数据源是来自于 Kafka 消息队列,然后解析 Kafka 里每一条数据。解析完成后,下发的数据我们会按照事件的 ID 进行 KeyBy,每个分组每 10 秒钟进行一次窗口的聚合。聚合处理完之后,消息会写到自定义的 Sink。以上是一个简单的作业描述,这个作业描述会映射到一个直观的逻辑拓扑。

可以看到逻辑拓扑里面有 4 个称为算子或者是运算的单元,分别是 Source、Map 、Ke yBy / W i n d ow / A pp l y 、Si n k,我们把逻辑拓扑称为 Str e ami n gDataflow。

资料来源:《8-Apache Flink 必知必会》,下载链接:https://developer.aliyun.com/topic/download?id=1189

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。