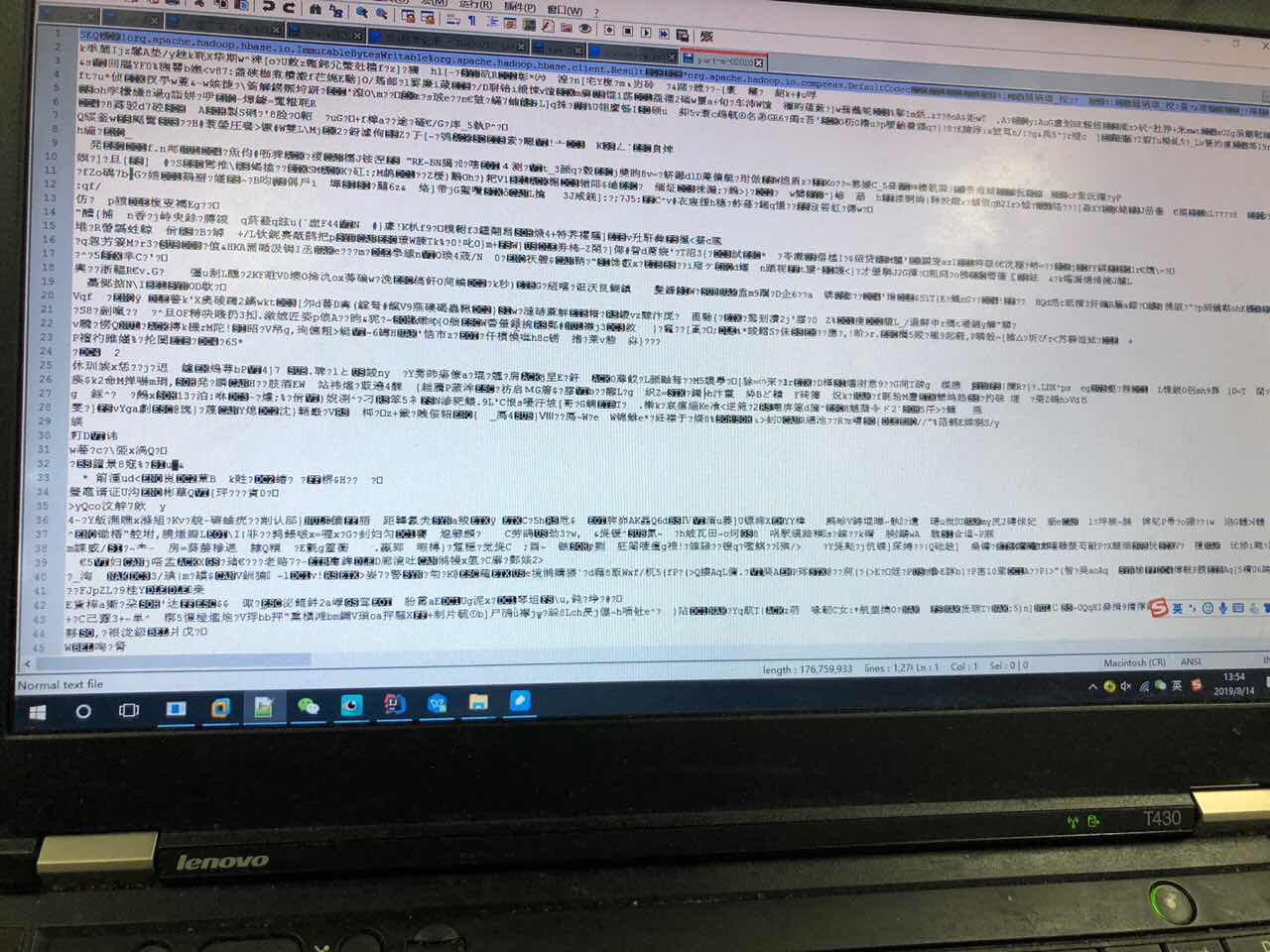

请问下我用hbase自带的导出表数据打开发现乱码,请问咋用bulkload导进去,需要改下rowkey?

本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在HBase中,如果你遇到导出数据后发现乱码的问题,这通常是因为字符编码不匹配导致的。在使用HBase的Bulk Load功能重新导入数据之前,确保解决乱码问题并正确处理rowkey和其他列族数据。

检查字符编码:首先确认你的数据在导出和导入过程中的字符编码是否一致。HBase默认使用UTF-8编码,确保你的数据文件也是用UTF-8编码存储的。

转换编码:如果数据文件不是UTF-8编码,可以使用如iconv(Linux命令行工具)将文件转换为UTF-8编码。例如:

iconv -f original_encoding -t UTF-8 input_file > output_file

CSV/TSV格式处理:如果你的数据是CSV或TSV格式,确保分隔符与数据内容不会冲突,并且所有字段都正确地被引用以避免解析错误。

创建HFile:使用MapReduce作业或者HBase提供的hbase org.apache.hadoop.hbase.mapreduce.ImportTsv工具将转换好的数据转换成HFile格式。如果是自定义数据格式,可能需要编写自定义的Mapper类来处理数据。

准备数据:确保你的数据文件格式符合Bulk Load的要求,特别是rowkey的设计。Rowkey设计应考虑查询模式,以优化读取性能。不需要因为乱码问题而直接修改rowkey,除非rowkey本身设计有误或不符合新的需求。

执行Bulk Load:使用completebulkload命令将生成的HFile导入到HBase表中。例如:

hbase org.apache.hadoop.hbase.mapreduce.LoadIncrementalHFiles -Dhbase.bulkload.staging.dir=/tmp/hbase-staging <output_dir> <table_name>

其中,<output_dir>是包含HFile的目录,<table_name>是要导入的HBase表名。

通过以上步骤,你应该能够解决乱码问题并成功使用Bulk Load导入数据到HBase中。