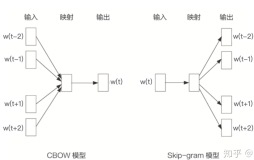

上一期介绍了word2vec的基本构思和skip-gram模型的创建,这一期将进行google的code review 也就是模型的具体迭代。

milkov2013的文章很难以理解,有以下论文对这篇论文进行了详细解读精读!

http://www-personal.umich.edu/~ronxin/pdf/w2vexp.pdf

skip-gram的计算问题

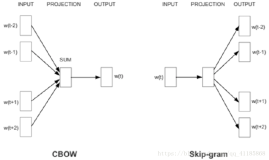

再上一次图,通过上次解析可以知道,对于每一个例如 input w(t)和output w(t-1) 的组合

在forward的时候

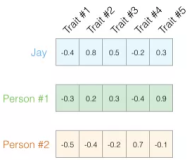

input->projection层实际上就是取了一列(或者一行),实际计算量为 H, H为hidden层个数,也就是word的vec维度

projection->output层计算为\(hw2\),上期中提到过\(h\)是H维的向量,\(w2\)是HV维的矩阵,因此这个计算要花费H*V次。

在back-propagation的时候

projection->output层

$$ w2^{new}_{ij}=w2^{old}_{ij}-η*(输出层的错误_i)*h_j $$

其中η为学习速度。

因此\(w2\)矩阵的更新也需要H*V次。

考虑到V词汇量通常为30000以上,而H通常在200左右。H*V的计算量难以承受。

解决方法

NEGATIVE SAMPLING

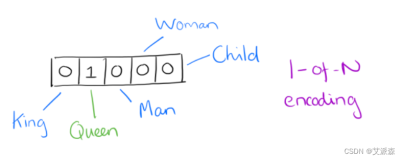

再回顾一下我们的input和output,input是单词本身的one-hot,而output是单词周围词的one-hot。 对于input=w(t),我们期望模型的输出o接近如w(t-1)=(0,0,0.....1,0...0). 在普通更新时,我们计算output层的error为一个V维量,然后更新所有\(w2\)。另一个策略是,我们不更新所有维度(V维),只更新1所在的维,和随机N个0所在维。这个就称NEGATIVE SAMPLING

代码分析

if (negative > 0) for (d = 0; d < negative + 1; d++) {

if (d == 0) {

target = word;

label = 1;

} else {

next_random = next_random * (unsigned long long)25214903917 + 11;

target = table[(next_random >> 16) % table_size];

if (target == word) continue;

label = 0;

}这一段代码中negative是指代negative sampling的数量。一般25足够。

for循环中,d=0的时候,是指代正样本的更新,word存储了output的one-hot表示中1所在列号(维)。

target就存储了这个列(维)号,label则存储了output的one-hot在这一列(维)的值。正样本时候就是1.

d不是0的时候,随机选择负样本列(维),next_random随机了一个数,然后mod table_size(就是mod V词汇量),如果target的数值是word(即正样本列号)就重新随机负样本列,label是0。

以上代码就决定了一个变量target,即要更新的one-hot列(维)。那么在forward的时候我们就只需要计算one-hot向量这一个列(维)的值。然后计算这一维的error,来更新\(w2\),和\(h\)变量。以下代码做了forward和back-propagation。

l2 = target * layer1_size;

f = 0;

for (c = 0; c < layer1_size; c++) f += neu1[c] * syn1neg[c + l2];

g=输出层error;

for (c = 0; c < layer1_size; c++) neu1e[c] += g * syn1neg[c + l2];

for (c = 0; c < layer1_size; c++) syn1neg[c + l2] += g * neu1[c];公式推导:

forward :

$$ o=h*w2_{.target} $$

back,derivation for h:

$$ h^{new}=h^{old}-η*输出层的错误*w2_{.target} $$

back,derivation for w2 column "target":

$$ w2^{new}_{.target}=w2^{old}_{.target}-η*输出层的错误*h $$

其中\(w2_{.target}\)为w2的target那一列。

联系google的代码,neu1数组为即为h,hidden层,syn1neg数组即为w2,只是把二维数组写成了一维,

l2 = target * layer1_size;计算了开始地址。

for (c = 0; c < layer1_size; c++) f += neu1[c] * syn1neg[c + l2];对应上面的foward得到o。从o和label得到输出层error g。

for (c = 0; c < layer1_size; c++) neu1e[c] += g * syn1neg[c + l2];对应上面derivation for h,可以看到是一致的。

for (c = 0; c < layer1_size; c++) syn1neg[c + l2] += g * neu1[c];对应上面derivation for w2 column "target",可以看到也是一致的。

NEGATIVE SAMPLING速度分析

不用NEGATIVE SAMPLING每次更新w2需要VH次运算,而现在需要negativeH次运算,假如negative 取20,V 是3万,那么NEGATIVE SAMPLING至少也能快上1500倍。也就是说用了以后能单机跑,不用就要分布式了。

NEGATIVE SAMPLING为什么能得到好的效果

NEGATIVE SAMPLING看上去非常水,竟然随机取了几列更新,这能行?

答:有人使用了很多高大上的方法来采样,比如什么gibt采样啊,不能是周围的词啊,等等,最终速度比NEGATIVE SAMPLING慢,效果没有任何区别。

那为什么NEGATIVE SAMPLING可行?

可以用两种方法来回答

最直接的回答是 实践表明它可行。

然后就是个人的理解了。

我的理解是,word2vec的宗旨中w(t)是由w(t-2),w(t-1)...来表示的,因此在更新时,对于1那个点,也就是正样本是有道理,而对于负样本,那么些0的地方其实不是那么有道理。那么负样本的选取其实也就没有那么重要了,NEGATIVE SAMPLING也就可行了。

下一期介绍另一种更新方式,请期待!