Abstractive Sentence Summarization with Attentive Recurrent Neural Networks

- Sumit Chopra et al., Facebook AI Research

- NAACL2016

- sentence level

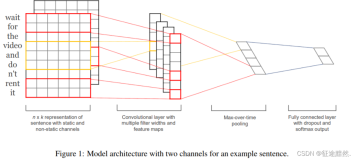

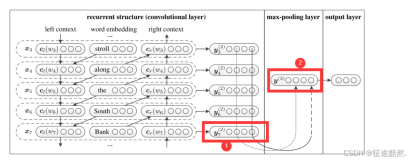

encoder: 使用了基于注意力的CNN

- 先将词的原始embedding(x_i)和位置embedding(l_i)(可训练)相加,作为词的full embedding(a_i)

- 然后使用size=5的一维卷积核做一个卷积操作,得到aggregate embedding(z_i)

- 计算attention:

h_t-1是t-1时刻的隐层状态(吧)

- 计算t时刻encoder的输出c_t:

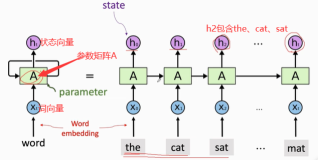

decoder: 普通的RNN和LSTM都试了

- 状态更新:

- 状态更新:

- 模型encoder的输入每次都是一个完整地句子,decoder每次要输出的时候,会将h_t-1给encoder,encoder根据句子和h_t-1计算attention生成c_t给decoder,然后decoder根据(y_t-1, h_t-1, c_t)计算要输出的单词。encoder还要更新position embedding(l_i)

性能(RAS-Elman, k=10, k means beam size):

- DUC-2004: Rouge-1:28.97/Rouge-2:8.26/Rouge-L:24.06

- Gigaword: Rouge-1:33.78/Rouge-2:15.97/Rouge-L:31.15