人类为什么要发明计算机?一直以来,人类都有爱偷懒的习惯,而正是由于这个原因,促使了人类发明了计算机,从而提高生产力,那么人类有了更多空闲时间去娱乐了~~

冯.诺依曼结构的工作原理

冯诺依曼结构的计算机由五大组成部分,分别是计算器、控制器、存储器(内存)、输入设备和输出设备,而计算机和控制器组成CPU(center process unit,中央处理单元)。冯.诺依曼结构的特点就是数据和指令以二进制形式,不加区别的存放在存储器中。以计算两个数相加为例,首先将相关代码和数据读入到内存中,编译器将相关代码编译成汇编代码。数据200和数据400分别存放在地址为1000、1004的地方,MOVE [1000] EAX 表示将地址是1000的内容放到寄存器EAX中,MOVE [1004] EBX 表示将地址是1004的内容放到寄存器EBX中,ADD EAX EBX 表示将EAX和EBX的内容相加,并将结果存放到EBX寄存器中。我们发现,简单的数据相加在汇编层面却对应着3条指令,如果更加复杂的数据运算就需要更加复杂的指令了。

计算机各个部件的连接方式

CPU通过I/O桥和内存相连,I/O桥和IO总线相连,IO总线挂载着USB控制器、图形控制器和磁盘控制器。

总线结构(不是所有的设备都是两两相连,而是通过总线结构)

- SOA也是总线结构,服务之间并不是两两相连的

- 代码存放在磁盘中,如果要运行代码,首先需要将磁盘中的代码放到内存中,然后CPU找到这段程序的第一个地址,例如找到main方法的地址

I/O桥是对南桥和北桥的抽象

- 北桥:连接的是快速设备,例如连接的是内存

- 南桥:连接的是慢速设备

指令和流水线

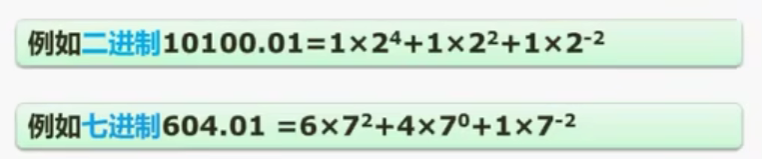

常见的指令格式有三地址指令、二地址指令、一地址指令和零地址指令,如下图所示,其中,二地址指令所占用的空间比三地址指令要少,x86系列的处理器就是采用二地址形式的;一地址指令通常被用作累加器;零地址指令地址比较紧凑,但是要完成一件事情,一般会比二地址或三地址指令需要更多的指令,例如

iconst_1

iconst_2

iadd

istore_0iadd(表示整形加法)指令并没有任何参数。连源地址都没有指定,零地址指令有什么作用?零地址意味着源和目标都是隐含参数,其实现依赖于一种常见的数据结构--栈。

指令的执行是分步骤的(取指、译码、执行等),也正是这个原因,它对应着不同的部件,这些部件我们要充分的利用起来,所以才有了流水线这个概念。如果不采用流水线,那么CPU的速度会变得很慢,譬如:当取值部件正在取值时,译码、执行部件是空闲的。所以,当一条指令在译码的时候,另一条指令从内存中取指令,这样做,取值部件和译码部件都可以利用起来了。

速度不匹配的问题---计算机的核心问题

下面这张图描述的是CPU、内存、硬盘和网络之间的速度差异,其中,CPU的速度是1s,主存速度是6min,硬盘速度是1~12个月,而网络速度则达到19年,我们发现这些设备的速度差别巨大,内存比CPU慢几百倍,硬盘比CPU慢几十万倍,网络比CPU慢千万倍,这样一来,CPU能坐等内存或硬盘慢吞吞的干活吗?或者说,有什么方法解决这种局面吗?

如何解决速度不匹配的问题

1. 提升硬盘等设备的速度,和CPU匹配(现阶段不可能)

2. 承认局限,但充分压榨CPU的能力,让CPU"忙死"

- 同步 -> 异步

异步经典的例子就是DMA(Direct Memory Access,直接内存访问),CPU发起一个硬盘读的操作之后,不等待硬盘完成,立刻去干别的事情,由DMA控制器来负责把数据从硬盘读到内存,完成后通知CPU。 - 顺序 -> 并发

顺序就是每个程序按序执行;并发就是在单个CPU上通过时间片切换方式实现执行不同指令,由于时间片很短,人类是感觉不出来的,因此我们感觉多个程序是并行执行的;而并行是在多个CPU上实现多个程序同时执行。

- 增加中间层

局部性原理分为时间局部性原理和空间局部性原理,时间局部性:如果程序中的某条指令一旦执行,则不久之后该指令可能再次被执行;如果某条数据被访问,则不就之后该数据可能被再次访问。空间局部性是指一旦程序访问了某个存储单元,则不久之后,其附近的存储单元也将被访问。