在机器学习领域,K近邻(KNN)算法以其简单直观的原理和出色的分类、回归能力而被广泛应用。然而,该算法面临计算复杂度高的问题,严重限制了其在大规模数据集和高维数据场景下的应用。以下是一些构建高效K近邻算法、降低计算复杂度的方法。

数据预处理

降维处理:采用主成分分析(PCA)、线性判别分析(LDA)等方法对数据进行降维。通过这些方法可以在保留数据主要特征的前提下,将高维数据映射到低维空间,减少计算距离时的维度,从而降低计算复杂度。

数据标准化:对数据进行标准化处理,将各个特征的值映射到相同的尺度范围内。这样可以避免由于特征尺度差异过大导致的距离计算偏差,同时也有助于提高算法的收敛速度和稳定性。

优化距离度量方式

选择合适的距离度量函数:根据数据的特点选择合适的距离度量方法,如欧式距离、曼哈顿距离、闵可夫斯基距离等。对于一些具有特定结构的数据,还可以考虑使用自定义的距离度量函数。

自适应距离度量:让算法能够根据数据的分布和特征自动调整距离度量的参数或方式。例如,在数据分布不均匀的情况下,可以为不同的特征赋予不同的权重,使得距离度量更能反映数据的真实相似性。

使用数据结构加速搜索

KD树:KD树是一种对K维空间中的实例点进行存储以便快速检索的树形数据结构。它通过不断地用垂直于坐标轴的超平面将K维空间切分,构成一系列的K维超矩形区域。利用KD树可以省去对大部分数据点的搜索,从而减少搜索的计算量,将算法复杂度从O(DN²)降低到O(DNlog(N))。

球树:球树是在KD树的基础上对性能进一步优化的数据结构。它以超球体作为划分空间的基本单元,相比KD树,球树在处理高维数据和非均匀分布数据时具有更好的性能。

局部敏感哈希(LSH):LSH是一种将高维空间中的数据映射到低维空间的哈希函数族。它的基本思想是将相似的数据点映射到同一个哈希桶中,使得在查询最近邻时只需要在哈希桶内进行搜索,大大减少了搜索范围,从而提高搜索效率。

近似最近邻算法

随机投影:通过随机生成的投影矩阵将高维数据投影到低维空间,然后在低维空间中进行最近邻搜索。虽然这种方法可能会引入一定的误差,但在大规模数据和高维数据场景下能够显著降低计算复杂度。

基于聚类的近似最近邻:先对训练数据进行聚类,将数据划分成多个簇。在查询最近邻时,首先找到查询点所属的簇,然后只在该簇及其相邻簇中进行搜索,而不是遍历整个数据集。

并行计算与分布式处理

并行计算:利用多核处理器、GPU或集群计算等并行计算资源,将距离计算和搜索任务分配到多个处理器或计算节点上同时进行,从而加快算法的运行速度。

分布式处理:采用分布式计算框架,如Hadoop、Spark等,将数据和计算任务分布到多个节点上进行处理。这样可以处理大规模的数据集,并且随着节点数量的增加,能够线性地提高计算能力。

融合其他算法

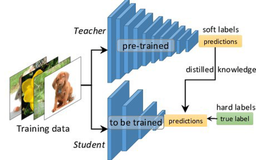

与神经网络融合:先使用神经网络进行特征提取,将原始数据映射到一个低维的特征空间,然后在这个特征空间中应用KNN算法进行分类或回归。

与聚类算法融合:先使用聚类算法对数据进行聚类,得到数据的簇结构。然后在每个簇内使用KNN算法进行局部的分类或回归。这样可以减少KNN算法的搜索范围,降低计算复杂度。