将潜在图像转换为视频生成器

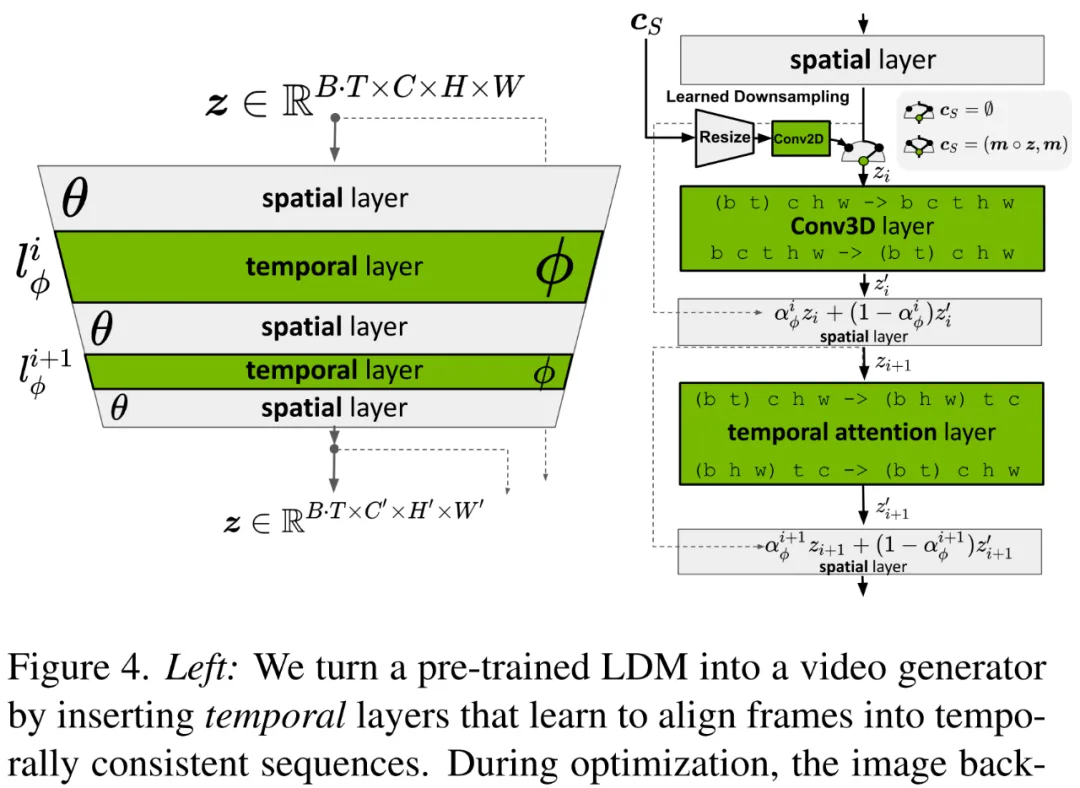

研究者高效训练视频生成模型的关键思路在于:重用预训练的固定图像生成模型,并利用了由参数 θ 参数化的 LDM。具体而言,他们实现了两个不同的时间混合层,即时间注意力和基于 3D 卷积的残差块。研究者使用正弦嵌入为模型提供了时间位置编码。具体流程如下图 4 所示。

用于长视频生成的预测模型

研究者还训练模型作为给定多个(首个)S 上下文帧的预测模型,通过引入时间二元掩膜 m_S 来实现。该掩膜 mask 了模型必须预测的 T − S 帧。此外研究者将该掩膜和 masked 编码视频帧馈入到模型中进行调节。

在推理过程中,为了生成长视频,研究者迭代地应用了采样过程,将最新的预测重新用作新的上下文。第一个初始序列通过从基础图像模型中合成单个上下文帧来生成,并基于此生成了一个新序列。然后以两个上下文帧为条件对动作进行编码。

用于高帧率的时间插值

高分辨率的特点不仅在于高空间分辨率,还在于高时间分辨率,即高帧率。为此研究者将高分辨率视频的合成过程分为了两部分,第一部分包括上文中的将潜在图像转换为视频生成器和用于长视频的预测模型,它们可以生成具有较大语义变化的关键帧,但受限于内存只能在较低帧率运行。第二部分则引入了一个额外模型,其任务是在给定关键帧之间进行插值。

研究者在实现过程中使用了掩膜调节机制。不过与预测任务不同,他们需要 mask 进行插值的帧,否则该机制保持不变,即图像模型被细化为视频插值模型。

超分辨率(SR)模型的时间微调

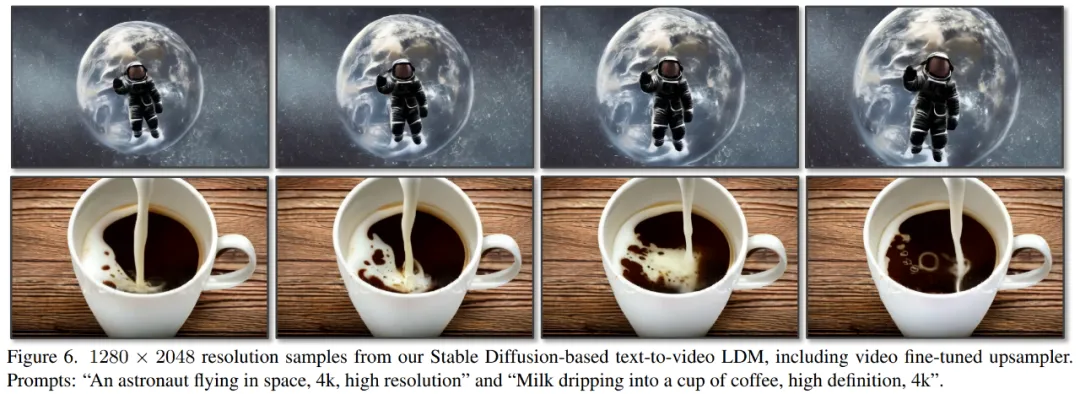

尽管 LDM 机制提供了很好的原始分辨率,但研究者的目标是将它推进到百万像素级别。他们从级联 DM 中获得灵感,并使用 DM 将 Video LDM 输出放大 4 倍。对于驾驶视频合成实验,研究者使用了像素空间 DM,并将分辨率扩大至 512×1024;对于文本到视频模型,他们使用了 LDM 上采样器,将分辨率扩大至 1280 × 2048。

实验结果

研究者专注于驾驶场景视频生成和文本到视频,因此使用了两个相关数据集,一个是真实驾驶场景(RDS)视频的内部数据集;另一个是 WebVid-10M 数据集,它将公开可用的 Stable Diffusion 图像 LDM 转换为了 Video LDM。

高分辨率驾驶视频合成

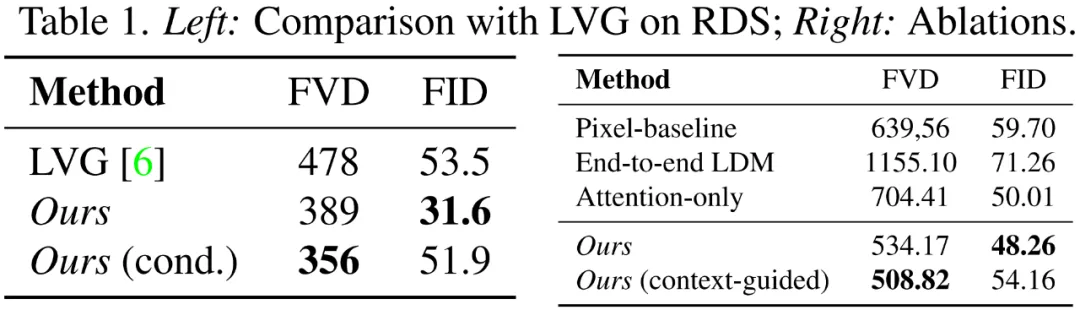

研究者在 RDS 数据集上训练 Video LDM pipeline,包括一个 4 倍像素空间视频上采样器。下表 1 显示了无上采样器时,128×256 分辨率下 Video LDM 的主要结果。研究者展示了有和无拥挤和白天 / 夜晚条件下其模型的性能。可以看到,Video LDM 通常优于 LVG,并且在一定条件下进一步降低了 FVD。

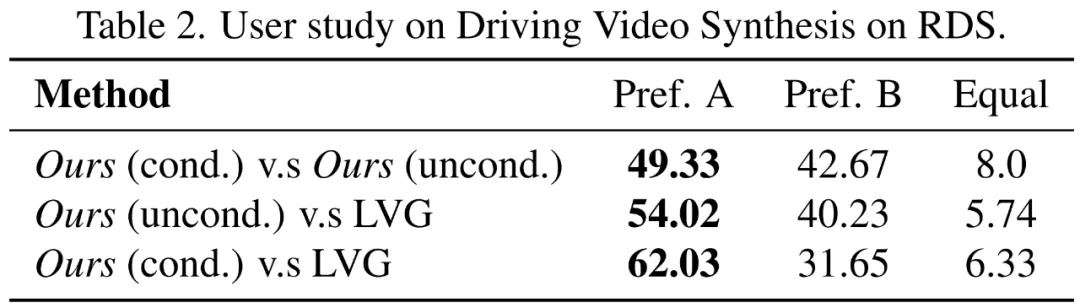

下表 2 显示了人类评估结果。就真实性而言,研究者的样本通常优于 LVG,并且来自条件模型的样本也优于无条件样本。

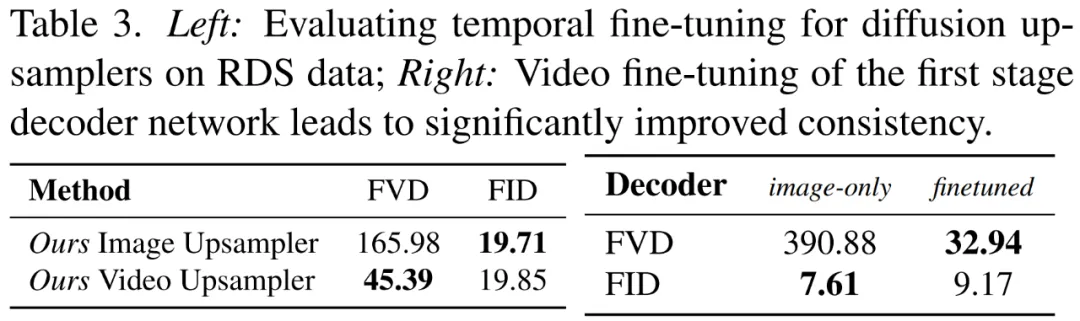

研究者将其视频微调像素空间上采样器与独立逐帧图像上采样做了比较,并使用了 128 × 256 30 fps 的真值视频进行调节,如下表 3 所示。

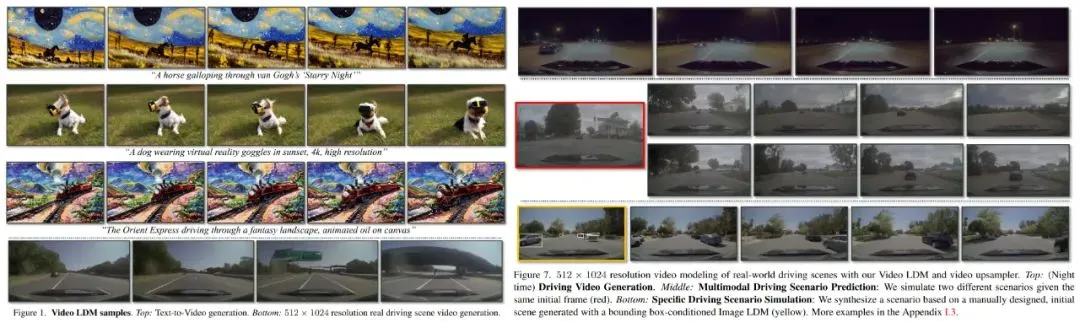

在下图左 1(底部)和图右 7(顶部)中,研究者展示了来自组合 Video LDM 和视频上采样器模型的条件样本。他们生成了高质量的视频。此外,研究者使用其预测方法生成了时间连贯的多分钟高分辨率驾驶长视频。

用 Stable Diffusion 做文本到视频生成

研究者没有先训练自己的 Image LDM 主干,其 Video LDM 方法可以利用并将现有的 Image LDM 转换为视频生成器。在本文中,他们将 Stable Diffusion 转换为了文本到视频生成器。

具体地,研究者使用 WebVid-10M 文本字幕视频数据集,训练了一个时间对齐版本的 Stable Diffusion 来做文本条件视频生成。他们在来自 WebVid 的帧上对 Stable Diffusion 的空间层进行简单微调,然后插入时间对齐层并训练它们(分辨率为 320 × 512)。研究者还在这些对齐层中添加了文本条件。

此外,研究者进一步对公开可用的潜在 Stable Diffusion 上采样器进行视频微调,使它支持 4 倍放大并生成分辨率为 1280 × 2048 的视频。研究者生成了由 113 帧组成的视频,并可以渲染成 4.7 秒的 24 fps 或 3.8 秒 30 fps 的片段。相关样本如上图 1 和下图 6 所示。

更多技术和实验细节请参阅原论文。