·阅读摘要:

本文提出了利用词向量+CNN/词向量+GRU来解决大规模数据下的多标签文本分类问题。

[1] Large Scale Multi-label Text Classification with Semantic Word Vectors

[0] 摘要

已有的多标签文本分类算法不考虑词序,选择使用词袋模型或TFIDF加权来创建文档向量。

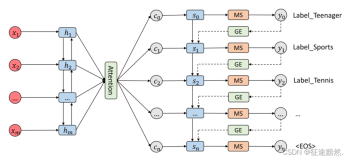

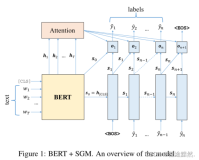

论文提出使用词嵌入和词序来提高多标签学习能力。使用卷积神经网络(CNN)和带有门控循环单元(GRU)的循环网络独立地用于预训练的word2vec嵌入,解决大规模的多标签文本分类问题。

【注一】:读到这里能发现论文发布地比较早。目前预训练的embedding已经很成熟了。

[1] 介绍

语义词向量还没有被用于多标签文本分类领域。相反,多标签学习算法对模型文本使用单词袋表示或TF-IDF加权,它不考虑词序,会限制训练中使用的词汇量。

为了克服这些缺点,论文提出在卷积神经网络(CNN)和带有门控循环单元(GRU)的循环神经网络模型中使用单词嵌入。

CNN模型和GRU模型的性能都超过了流行的 二进制相关性方法。

【注二】:二进制相关性方法在下面有介绍。

[2] 相关工作

[2.1] 多标签文本分类概述⭐

解决多标签学习的算法可以大致分为三种:

1、多标签分类;

2、标签排序;

3、多标签排序;

多标签分类算法接受一个输入X,然后生成两部分的集合Y和¯Y,其中Y是相关标签的集合,而¯Y是Y的补码。

标签排名并不决定一个分区,而是将标签从相关到不相关排序,索引越低表明相关性越高。

多标签排序被看作是两者的结合,因为它产生标签的排序,以及一个双分区。也就是说,算法的目标是让Y中的标签比¯Y中的所有标签都要高。然后学习或手动设置阈值函数,以确定排序后的数组中有多少标签是相关的。

[2.2] 二进制关联(BR)方法

该方法将多标签问题转化为一组多个二分类问题,其中每个问题对应一个特定的标签。

该方法有下列缺点:

1、首先,二元关联假设标签是独立的,这通常是一个错误的假设;

2、由于丢弃标签相关性,BR常常无法预测不同的组合或标签,从而导致性能下降;

3、数据集的不平衡也会对分类器产生更大的影响,因为负面例子的数量往往超过正面例子;

4、BR可能会训练不必要数量的分类器。

[2.3] 前馈网络

论文介绍了2种损失函数地计算方法:

1、Zhang提出的

2、Nam提出的使用标准的交叉熵误差函数代替Zhang提出的误差函数。

【注三】:交叉熵误差函数很重要,实现方法参考:https://blog.csdn.net/qq_43592352/article/details/122784389

[3] 卷积神经网络

与Kim在2014年发布的TextCNN网络模型基本一致。

[4] 门控循环神经网络

其实就是LSTM。